Bộ tăng tốc AI HGX H200 của NVIDIA được cải thiện đáng kể trong việc suy diễn Llama 3.1 nhờ thuật toán giải mã độc quyền “Medusa.”

NVIDIA Tiếp Tục Phát Triển Trong Lĩnh Vực Hệ Sinh Thái Phần Mềm, Đạt Hiệu Suất Cao Nhờ Medusa

Khi các mô hình ngôn ngữ lớn (LLMs) ngày càng phức tạp và có kích thước lớn hơn, việc sử dụng nhiều GPU để tính toán trở thành điều cần thiết nhằm cung cấp độ trễ thấp và hiệu suất cao mà các ứng dụng AI sinh tạo trong thời gian thực yêu cầu.

Hiệu suất phụ thuộc vào khả năng xử lý yêu cầu của các GPU kết hợp như thể chúng là “một GPU mạnh mẽ” với khả năng giao tiếp cực nhanh giữa các GPU và phần mềm tiên tiến có thể tận dụng tối đa sức mạnh của nhiều GPU. Bằng cách phân chia các phép tính của từng lớp mô hình trên các GPU sẵn có thông qua kỹ thuật gọi là song song tensor kết hợp với các thuật toán tiên tiến như giải mã giả định, độ trễ trong việc tạo ra token có thể giảm xuống, từ đó mang đến trải nghiệm người dùng tương tác tốt hơn.

Để phục vụ Llama 3.1 với độ trễ rất thấp, dịch vụ đám mây có thể sử dụng máy chủ NVIDIA HGX H200 với tám GPU H200 và bốn chip NVLink Switch. Các GPU trong máy chủ giao tiếp qua NVLink Switch với băng thông tối đa 900 GB/s, điều này giúp tránh tắc nghẽn trong các tình huống tương tác.

Để thực hiện các thuật toán tối ưu hóa trên hệ thống NVIDIA H200 HGX, người ta sử dụng TensorRT-LLM. Đây là thư viện mã nguồn mở của TensorRT, cho phép hiệu suất suy diễn hàng đầu cho các LLM mới nhất bằng nhiều kỹ thuật khác nhau như song song tensor và giải mã suy đoán.

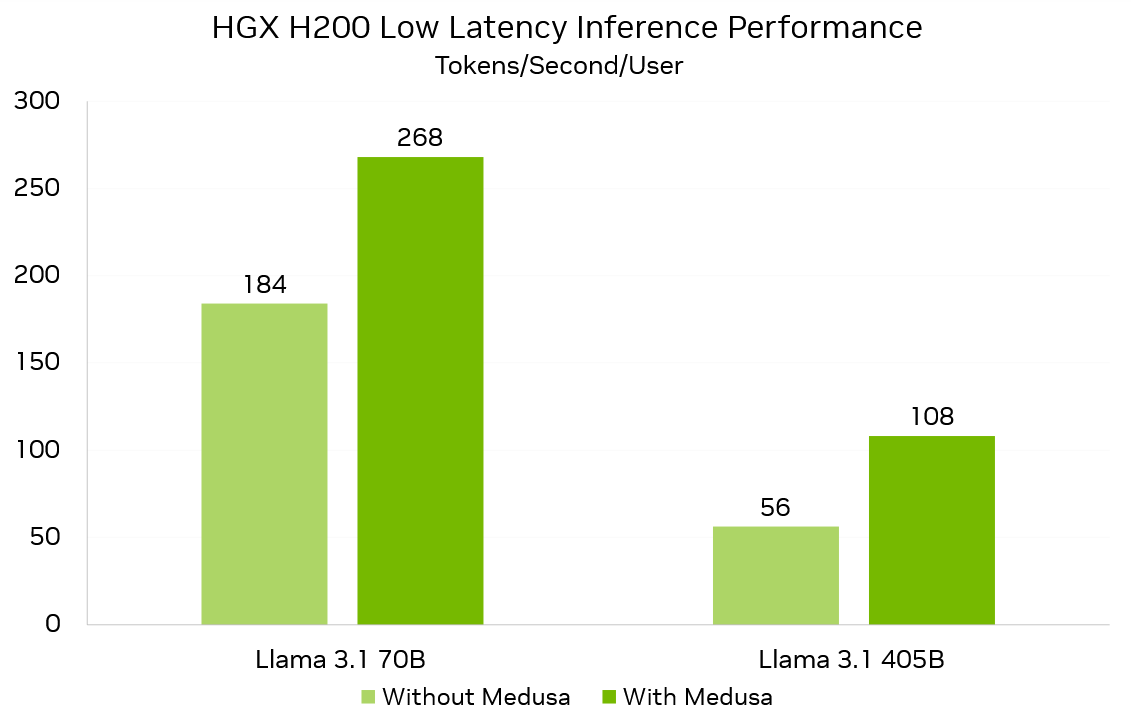

Các tối ưu hóa sắp tới của TensorRT-LLM, bao gồm cải tiến thuật toán giải mã suy đoán Medusa, sẽ mang lại hiệu suất độ trễ thấp xuất sắc cho Llama 3.1 70B và 405B lần lượt là 268 token/giây/người dùng và 108 token/giây/người dùng trên HGX H200.

Medusa tăng cường khả năng tạo token lên đến 1.9 lần trên NVIDIA HGX H200.

Các LLM dựa trên Transformer là tự hồi quy, nghĩa là các token cần được tạo ra theo thứ tự, giới hạn lưu lượng tạo token chỉ một token tại mỗi bước. Tốc độ tạo token phụ thuộc vào tốc độ tải trọng số mô hình vào bộ nhớ, dẫn đến việc GPU H200 không phát huy hết khả năng Tensor Core.

Giải mã suy đoán là kỹ thuật tăng tốc độ tạo token bằng cách sử dụng “mô hình phác thảo” để dự đoán nhiều token tiếp theo. Mô hình LLM sau đó “tập hợp” các dự đoán và xác thực song song với token tiếp theo, tận dụng hiệu quả tài nguyên tính toán song song trên GPU. Nếu LLM chấp nhận bất kỳ chuỗi nào, nhiều token sẽ được tạo trong bước sinh.

Medusa, được mô tả trong bài viết này, là một thuật toán giải mã suy đoán sử dụng mô hình gốc làm mô hình phác thảo, giảm thiểu độ phức tạp hệ thống. Kỹ thuật này sử dụng thêm “đầu” giải mã, gọi là Medusa heads, để dự đoán các token tiếp theo. Mỗi Medusa head tạo ra phân phối token vượt xa token trước đó.

Với Medusa, HGX H200 có thể tạo ra 268 token mỗi giây cho Llama 3.1 70B và 108 cho Llama 3.1 405B. Điều này nhanh hơn 1.5 lần so với Llama 3.1 70B và hơn 1.9 lần với Llama 3.1 405B khi không có Medusa. Mặc dù tỷ lệ chấp nhận Medusa thay đổi giữa các tác vụ tùy thuộc vào cách tinh chỉnh các đầu, hiệu suất tổng thể của nó vẫn ổn định trên nhiều loại tác vụ.

Các đầu Medusa cho Llama 3.1 70B và 405B được huấn luyện bằng NVIDIA TensorRT Model Optimizer kết hợp với khung làm việc NVIDIA NeMo. Huấn luyện đầu Medusa sử dụng một cấu trúc nền cố định, đảm bảo độ chính xác giống như mô hình cơ bản.

Đổi mới toàn diện của NVIDIA không ngừng.

NVIDIA HGX H200 với NVLink Switch và TensorRT-LLM mang lại hiệu suất suy diễn thời gian thực xuất sắc trên các mô hình phổ biến. Để nâng cao trải nghiệm người dùng và giảm chi phí suy diễn, chúng tôi không ngừng đổi mới ở mọi cấp độ công nghệ – từ vi mạch, hệ thống, thư viện phần mềm đến thuật toán.

Chúng tôi sẽ sớm cập nhật về hiệu suất suy diễn độ trễ thấp khi nền tảng và hệ sinh thái LLM phát triển.

Theo WCCFTECH