AMD’s Instinct MI300 đã nhanh chóng khẳng định vị thế quan trọng trong thị trường bộ tăng tốc AI, đóng góp đáng kể vào sự tăng trưởng doanh thu. Dù không thể so sánh với vị trí thống trị của Nvidia, nhưng những tiến bộ của AMD cho thấy triển vọng hứa hẹn trong lĩnh vực phần cứng AI.

Card đồ họa Instinct MI300 vừa được AMD ra mắt đã trở thành một nguồn doanh thu lớn cho công ty, cạnh tranh mạnh mẽ với toàn bộ doanh thu từ các sản phẩm CPU của mình. Đây là một cột mốc quan trọng đối với AMD trong thị trường phần cứng AI đang rất cạnh tranh, nơi mà công ty thường bị tụt lại so với Nvidia dẫn đầu ngành.

Trong cuộc gọi kết quả kinh doanh gần đây, CEO AMD Lisa Su cho biết rằng mảng GPU trung tâm dữ liệu, chủ yếu nhờ vào Instinct MI300, đã vượt qua các kỳ vọng ban đầu. “Chúng tôi thực sự nhìn thấy kinh doanh GPU [AI] của mình đang dần đạt được quy mô như kinh doanh CPU,” bà nói.

Thành tựu này đặc biệt ấn tượng bởi vì mảng CPU của AMD bao gồm nhiều sản phẩm khác nhau phục vụ cho máy chủ, điện toán đám mây, máy tính để bàn và laptop.

Instinct MI300, được giới thiệu vào tháng 11 năm 2023, đại diện cho card đồ họa cạnh tranh thực sự đầu tiên của AMD dành cho các công việc suy diễn và đào tạo AI. Mặc dù mới ra mắt chưa lâu, nhưng MI300 đã nhanh chóng thu hút được sự chú ý trên thị trường.

Các nhà phân tích tài chính ước tính doanh thu từ GPU AI của AMD trong tháng 9 vừa qua đã vượt qua mức 1,5 tỷ USD, với khả năng các tháng tiếp theo sẽ còn mạnh hơn nữa.

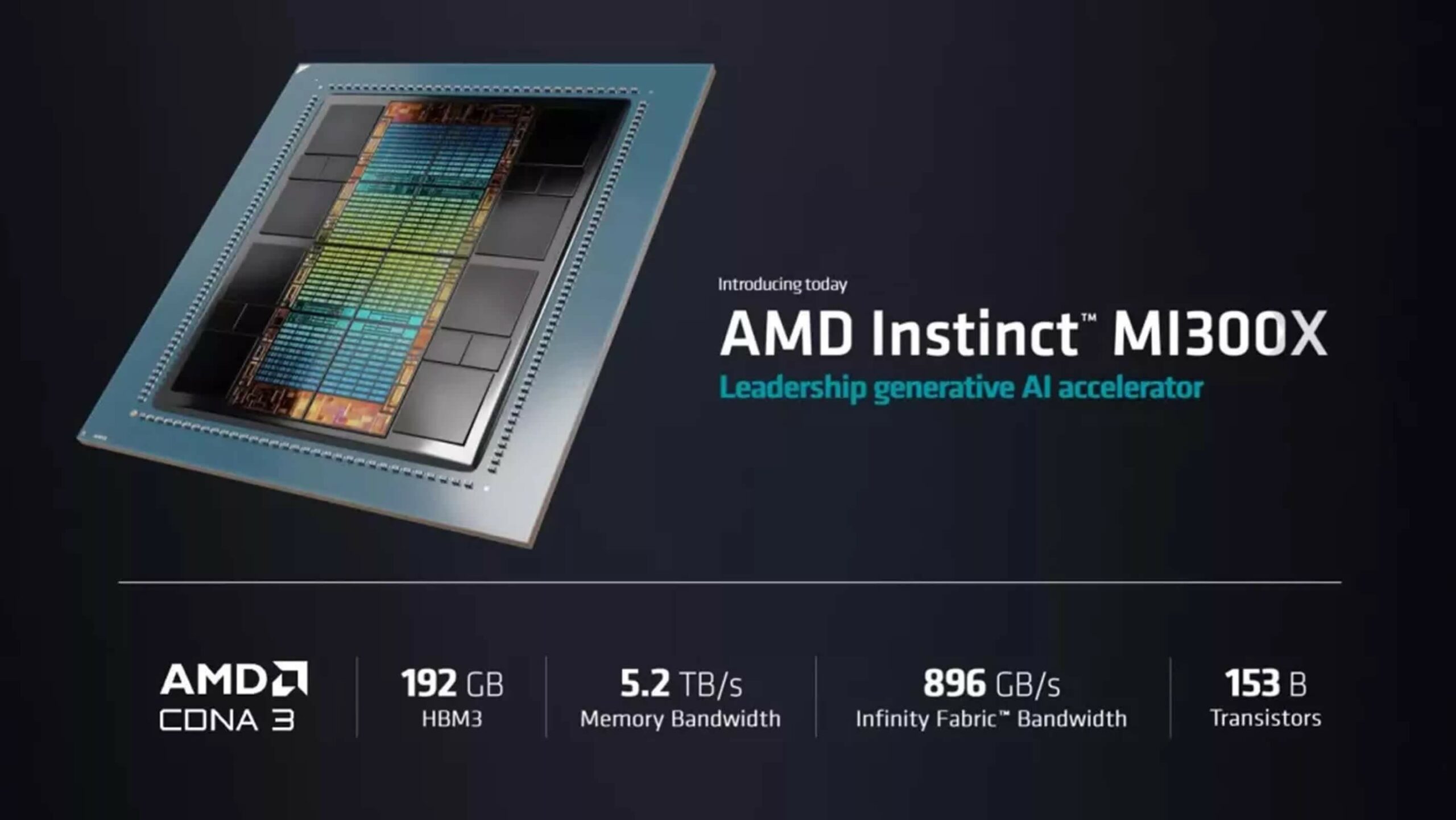

Thông số kỹ thuật của MI300 rất cạnh tranh trên thị trường bộ tăng tốc AI, cung cấp những cải tiến đáng kể về dung lượng bộ nhớ và băng thông.

Bộ xử lý đồ họa MI300X sở hữu 304 đơn vị tính toán GPU cùng với 192 GB bộ nhớ HBM3, mang lại băng thông bộ nhớ lý thuyết tối đa lên đến 5.3 TB/s. Nó đạt hiệu suất tính toán ma trận FP64/FP32 tối đa là 163.4 TFLOPS và hiệu suất FP8 đỉnh điểm lên tới 2,614.9 TFLOPS.

APU MI300A tích hợp 24 lõi CPU Zen 4 x86 cùng với 228 đơn vị tính toán GPU. Nó có 128 GB bộ nhớ HBM3 thống nhất và đạt băng thông bộ nhớ lý thuyết tối đa tương đương với MI300X là 5.3 TB/s. Hiệu suất tính toán ma trận FP64/FP32 tối đa của MI300A đạt 122.6 TFLOPS.

Sự thành công của Instinct MI300 đã thu hút sự quan tâm từ các nhà cung cấp điện toán đám mây lớn như Microsoft. Gã khổng lồ Windows gần đây đã công bố khả năng cung cấp chung cho dòng VM ND MI300X của mình, với tám bộ tăng tốc AMD MI300X. Vào đầu năm nay, Phó Chủ tịch điều hành về Cloud và AI của Microsoft, Scott Guthrie, cho biết rằng bộ tăng tốc của AMD hiện đang là GPU hiệu quả về chi phí nhất dựa trên hiệu suất của chúng trong Dịch vụ AI Azure.

Mặc dù sự phát triển của AMD trên thị trường GPU AI là ấn tượng, công ty vẫn chưa theo kịp Nvidia về thị phần tổng thể. Các nhà phân tích dự đoán rằng Nvidia có thể đạt doanh thu từ bán GPU AI ở mức 50 đến 60 tỷ USD vào năm 2025, trong khi AMD chỉ có thể đạt tối đa 10 tỷ USD.

Tuy nhiên, Giám đốc Tài chính của AMD, Jean Hu, đã chỉ ra rằng công ty đang làm việc với hơn 100 mối quan hệ khách hàng cho dòng sản phẩm MI300, bao gồm các công ty công nghệ lớn như Microsoft, Meta và Oracle, cũng như một tập hợp rộng rãi các khách hàng doanh nghiệp.

Sự thành công nhanh chóng của Instinct MI300 trên thị trường AI đặt ra câu hỏi về định hướng tương lai của AMD đối với thẻ đồ họa tiêu dùng, vì doanh thu cao hơn từ bộ tăng tốc AI có thể ảnh hưởng đến cách thức phân bổ tài nguyên của công ty. Tuy nhiên, AMD đã xác nhận cam kết của mình đối với thị trường GPU tiêu dùng, với Su thông báo rằng kiến trúc RDNA 4 thế hệ tiếp theo, có khả năng sẽ ra mắt trên Radeon RX 8800 XT, sẽ được trình làng vào đầu năm 2025.

Theo Techspot