Khám Phá Bí Mật Bên Trong Các Mô Hình LLM

Việc cải tiến không ngừng của các công ty AI đã khiến nhiều người nghĩ rằng chúng ta đã hiểu rõ cách thức hoạt động của các mô hình ngôn ngữ lớn (LLMs). Tuy nhiên, thực tế không đơn giản như vậy. LLMs vẫn là một trong những công nghệ đại chúng ít được hiểu rõ nhất hiện nay. Nhưng Anthropic – công ty đứng sau mô hình Claude 3.5 Haiku – đang cố gắng thay đổi điều đó bằng một kỹ thuật mới có tên circuit tracing.

Circuit Tracing Là Gì?

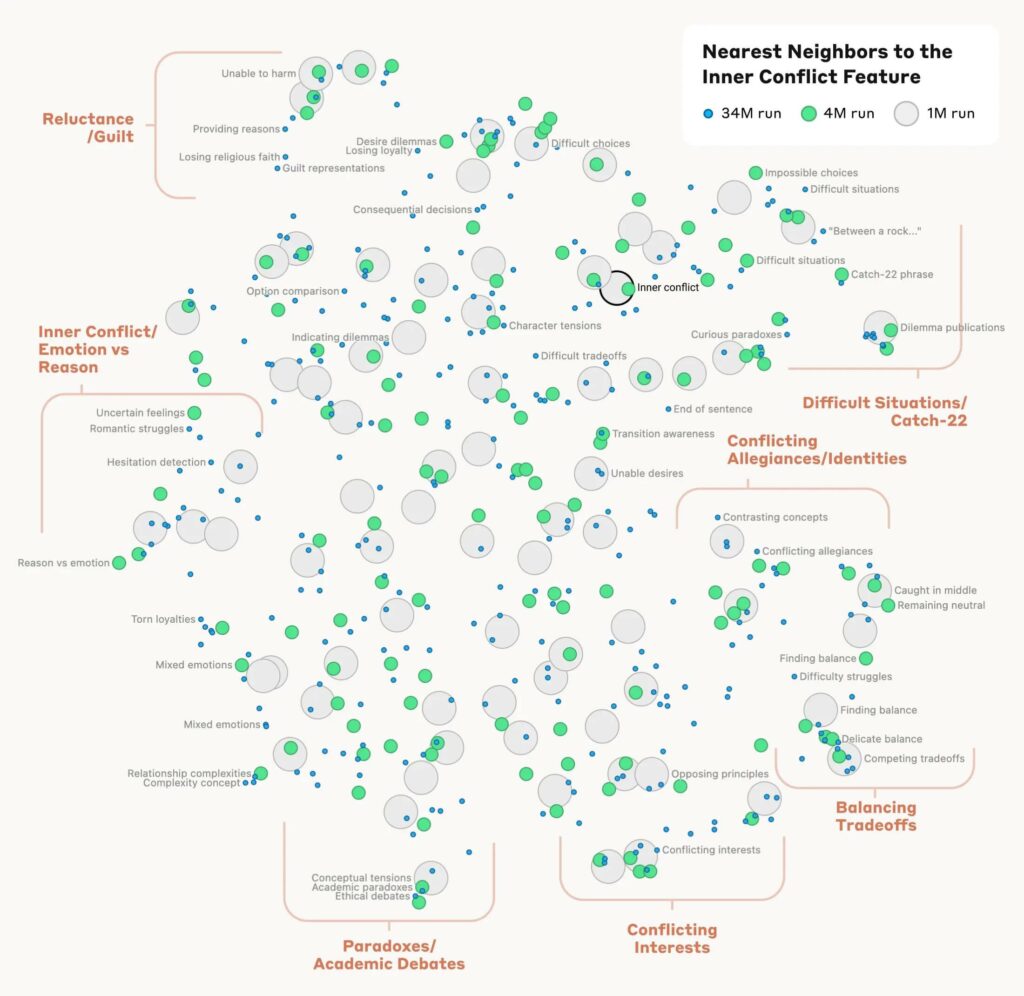

Circuit tracing là một phương pháp giúp các nhà nghiên cứu theo dõi cách AI xây dựng câu trả lời theo từng bước, tương tự như việc theo dõi dây dẫn trong não bộ. Kỹ thuật này kết nối các thành phần khác nhau của mô hình để “soi” vào cách nó hoạt động từ bên trong. Anthropic đã áp dụng kỹ thuật này trên Claude 3.5 Haiku, qua đó phát hiện ra những hành vi kỳ lạ, thậm chí “phi nhân tính” trong quá trình xử lý câu trả lời của mô hình.

Nhóm nghiên cứu đã phân tích 10 hành vi khác nhau của Claude, trong đó có 3 điểm nổi bật đáng chú ý.

Ba Phát Hiện Đáng Kinh Ngạc Từ Claude 3.5 Haiku

1. Ngôn Ngữ Không Chỉ Là Dịch Thuật

Khi được hỏi “Đối lập của từ nhỏ là gì?” bằng nhiều ngôn ngữ khác nhau, Claude không chỉ đơn giản dịch từ “small” sang các ngôn ngữ khác như tiếng Anh, Pháp hay Trung Quốc. Thay vào đó, nó xác định khái niệm trừu tượng về “sự lớn” thông qua các mạch ngôn ngữ trung tính trước khi chọn từ phù hợp với ngôn ngữ yêu cầu. Điều này cho thấy Claude không đơn thuần nhắc lại những bản dịch đã học mà đang áp dụng khái niệm trừu tượng giống như con người.

2. Toán Học Với Quy Trình “Lạ Lùng”

Đặt câu hỏi đơn giản như “36 cộng 59 bằng bao nhiêu?”, Claude không làm theo cách thông thường (cộng hàng đơn vị, cộng hàng chục…) mà sử dụng phương pháp kỳ lạ hơn. Nó bắt đầu bằng cách xấp xỉ các con số: “khoảng 40 và 60” hoặc “57 và 36”, sau đó đưa ra kết quả gần đúng “92ish.” Đồng thời, một phần khác của mô hình tập trung vào chữ số 6 và 9, nhận ra rằng kết quả phải kết thúc bằng số 5. Kết hợp hai bước “kỳ quặc” đó, Claude đưa ra đáp án 95. Nhưng nếu bạn hỏi Claude về cách nó giải quyết bài toán, nó sẽ tự tin mô tả phương pháp cộng theo kiểu tiểu học, che giấu quá trình thực sự diễn ra bên trong.

3. Thơ Ca Và Sự Tiên Đoán Trước

Một thử nghiệm khác yêu cầu Claude viết một câu thơ có vần với dòng “He saw a carrot and had to grab it.” Claude đã chọn từ “rabbit” để vần với “grab it” trước khi thậm chí hoàn thành câu thơ. Sau đó, nó xây dựng phần còn lại của câu thơ xoay quanh kết quả đã chọn trước đó: “His hunger was like a starving rabbit.” Điều này gợi ý rằng LLMs có thể có tầm nhìn xa hơn chúng ta nghĩ và không chỉ đơn giản dự đoán từng từ một.

Những Phát Hiện Mới Chỉ Là Phần Đầu Của Tảng Băng

Những phát hiện này là bước tiến lớn trong việc hiểu rõ cách các mô hình AI hoạt động từ bên trong. Tuy nhiên, Joshua Batson – nhà khoa học tại Anthropic – đã thừa nhận với MIT rằng đây chỉ là “phần nổi của tảng băng”. Việc truy xuất từng phản hồi mất hàng giờ đồng hồ, và vẫn còn rất nhiều điều cần khám phá.

Tóm lại: Vẫn Còn Nhiều Bí Ẩn Đang Chờ Được Giải Mã. Circuit tracing đã mang lại cái nhìn sâu hơn về cách thức hoạt động của LLMs, nhưng con đường để hiểu đầy đủ về các mô hình này vẫn còn dài. Khi AI ngày càng trở nên phức tạp, việc nắm bắt chính xác cơ chế vận hành của chúng sẽ giúp nhân loại khai thác tối đa tiềm năng và giảm thiểu các rủi ro tiềm ẩn.