Google Cloud đang củng cố vị thế cạnh tranh trong lĩnh vực điện toán AI đang phát triển nhanh chóng bằng cách tích hợp phần cứng thiết kế riêng như Trillium với GPU hàng đầu của Nvidia. Những tiến bộ mới nhất hứa hẹn sẽ đẩy nhanh việc phát triển và triển khai các mô hình và ứng dụng AI phức tạp trên nhiều ngành công nghiệp.

Gần đây, Google Cloud đã công bố nâng cấp đáng kể cơ sở hạ tầng AI, giới thiệu các giải pháp phần cứng và phần mềm mới nhằm đáp ứng nhu cầu ngày càng tăng của khối lượng công việc trí tuệ nhân tạo. Trọng tâm của những thay đổi này là việc ra mắt Trillium, Bộ xử lý Tensor (TPU) thế hệ thứ sáu của Google.

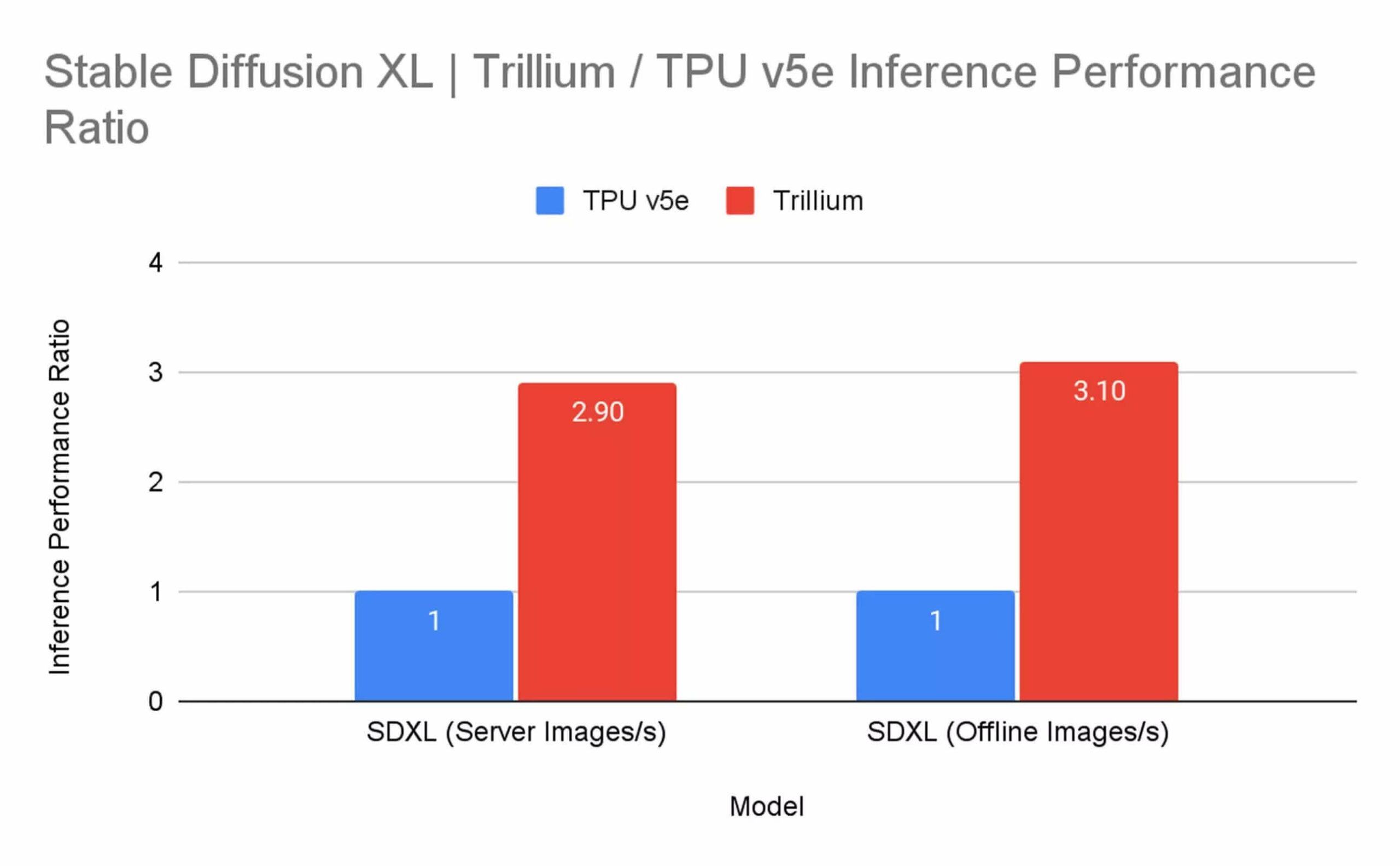

So với phiên bản tiền nhiệm TPU v5e, Trillium mang lại hiệu suất đào tạo gấp hơn bốn lần và thông lượng suy luận gấp ba lần. Cải tiến này đi kèm với việc tăng 67% hiệu suất năng lượng.

TPU mới tự hào với các thông số kỹ thuật ấn tượng, bao gồm dung lượng Bộ nhớ băng thông cao (HBM) và băng thông Liên kết liên chip (ICI) gấp đôi, khiến Trillium đặc biệt phù hợp để xử lý các mô hình ngôn ngữ lớn như Gemma 2 và Llama, cũng như các tác vụ suy luận chuyên sâu về tính toán như các tác vụ được yêu cầu bởi các mô hình khuếch tán như Stable Diffusion XL.

Điểm mạnh nổi bật của Trillium nằm ở khả năng mở rộng. Một pod đơn lẻ với băng thông cao và độ trễ thấp có thể tích hợp tới 256 chip Trillium, và cấu hình này có thể được nhân rộng lên tới hàng trăm pod, tạo ra một siêu máy tính quy mô tòa nhà được kết nối bởi mạng trung tâm dữ liệu Jupiter của Google với dung lượng 13 petabit mỗi giây. Phần mềm Multislice của Trillium cho phép khả năng mở rộng hiệu suất gần như tuyến tính trên các cụm khổng lồ này.

Các bài kiểm tra chuẩn của Google nhằm mục đích minh chứng năng lực của Trillium. So với TPU v5e, hiệu suất huấn luyện cho các mô hình như Gemma 2-27b, MaxText Default-32b và Llama2-70B đã tăng hơn bốn lần. Đối với các tác vụ suy luận, Trillium đạt được thông lượng gấp ba lần khi chạy Stable Diffusion XL.

Google Cloud vừa công bố kế hoạch ra mắt máy ảo A3 Ultra (VM) sử dụng GPU H200 Tensor Core của Nvidia, đồng thời với việc triển khai Trillium. Dự kiến ra mắt bản xem trước vào tháng tới, dòng máy ảo mới này hứa hẹn sẽ tăng gấp đôi băng thông mạng GPU-GPU so với phiên bản tiền nhiệm là A3 Mega VM.

Máy ảo A3 Ultra được thiết kế để mang lại hiệu suất gấp đôi cho các tác vụ suy luận LLM, nhờ dung lượng bộ nhớ gần gấp đôi và băng thông bộ nhớ cao hơn 1,4 lần so với A3 Mega VM. Dòng máy ảo này cũng sẽ khả dụng thông qua Google Kubernetes Engine.

Ngoài ra, Google Cloud cũng đang triển khai Hypercompute Cluster, một hệ thống phân cụm có khả năng mở rộng cao nhằm đơn giản hóa việc triển khai và quản lý cơ sở hạ tầng AI quy mô lớn. Hệ thống này cho phép khách hàng quản lý hàng nghìn bộ tăng tốc như một đơn vị thống nhất.