TỔNG QUAN: Nvidia chiếm lĩnh từ 75 đến 90% thị trường chip AI. Chính sự thống trị này đã thúc đẩy các đối thủ công nghệ lớn và các nhà cung cấp dịch vụ đám mây phát triển phần cứng và bộ tăng tốc riêng nhằm cạnh tranh với đế chế AI của công ty. Microsoft hiện đã sẵn sàng công bố chi tiết về chip AI tùy chỉnh đầu tiên của mình.

Tại hội nghị Hot Chips năm nay, Microsoft đã giới thiệu bộ tăng tốc AI đầu tiên mang tên Maia 100. Bộ tăng tốc này có kiến trúc sử dụng bảng máy chủ tùy chỉnh, giá đỡ và phần mềm để cung cấp giải pháp hiệu quả về chi phí cũng như hiệu suất cao cho các tác vụ dựa trên AI. Redmond đã thiết kế bộ tăng tốc tùy chỉnh này để chạy các mô hình OpenAI trên các trung tâm dữ liệu Azure của chính họ.

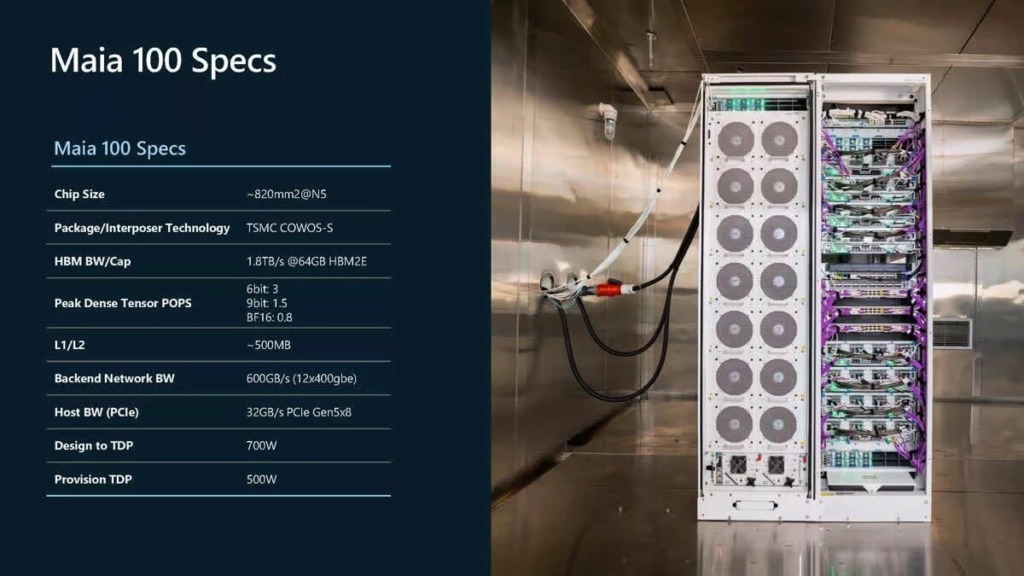

Các chip này được sản xuất trên quy trình 5nm của TSMC và có thông số kỹ thuật là 500w nhưng có thể hỗ trợ tối đa lên đến 700w TDP.

Thiết kế của Maia có khả năng cung cấp hiệu suất tổng thể cao trong khi quản lý hiệu quả mức tiêu thụ điện năng của tải công việc mà nó hướng tới. Bộ tăng tốc này cũng được trang bị 64GB HBM2E, thấp hơn so với 80GB của Nvidia H100 và 192GB HBM3E của B200.

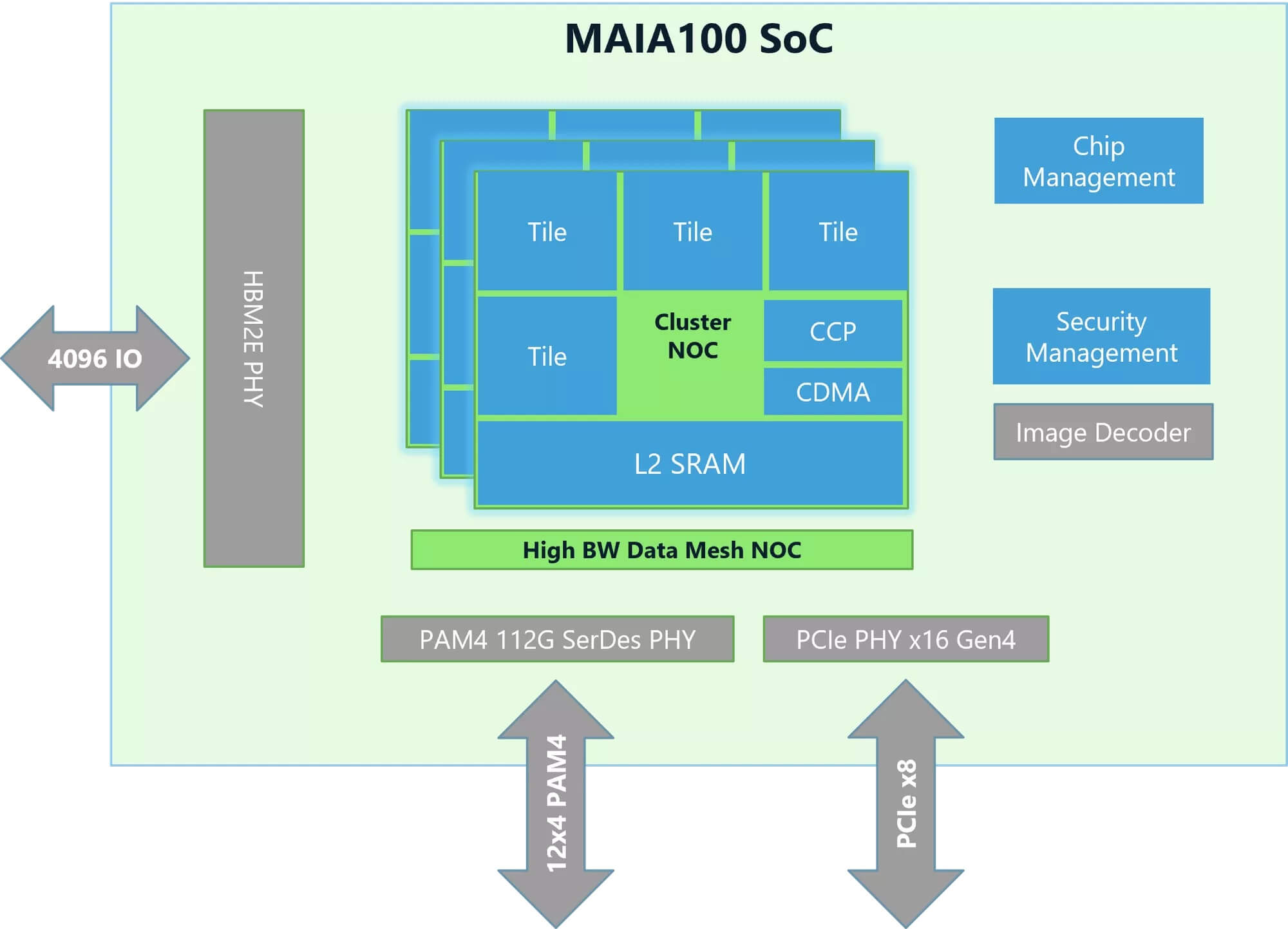

Theo Microsoft, kiến trúc Maia 100 SoC bao gồm một đơn vị tensor tốc độ cao (16xRx16) giúp tăng cường khả năng xử lý nhanh cho việc huấn luyện và suy diễn, đồng thời hỗ trợ nhiều loại dữ liệu khác nhau, bao gồm cả các loại độ chính xác thấp như định dạng MX của Microsoft.

Kiến trúc này có một động cơ superscalar lỏng lẻo (bộ xử lý vector) được thiết kế với ISA tùy chỉnh để hỗ trợ các loại dữ liệu, bao gồm FP32 và BF16, một động cơ Truy cập Bộ nhớ Trực tiếp hỗ trợ các phương thức phân mảnh tensor khác nhau, cùng với các semaphore phần cứng cho phép lập trình bất đồng bộ.

Bộ tăng tốc AI Maia 100 cũng cung cấp cho các nhà phát triển bộ công cụ phát triển phần mềm Maia SDK. Bộ công cụ này bao gồm các công cụ giúp các nhà phát triển AI nhanh chóng chuyển đổi các mô hình đã được viết trước đó bằng Pytorch và Triton.

SDK bao gồm sự tích hợp framework, công cụ dành cho nhà phát triển, hai mô hình lập trình và các trình biên dịch. Nó còn có các kernel tính toán và giao tiếp tối ưu, runtime Maia Host/Device, cùng với một lớp trừu tượng phần cứng hỗ trợ việc phân bổ bộ nhớ, khởi động kernel, lập lịch và quản lý thiết bị.

Microsoft đã cung cấp thêm thông tin về SDK, giao thức mạng backend của Maia và tối ưu hóa trong bài viết blog “Inside Maia 100”. Đây là một tài liệu thú vị dành cho các nhà phát triển và những người đam mê AI.

Theo Techspot