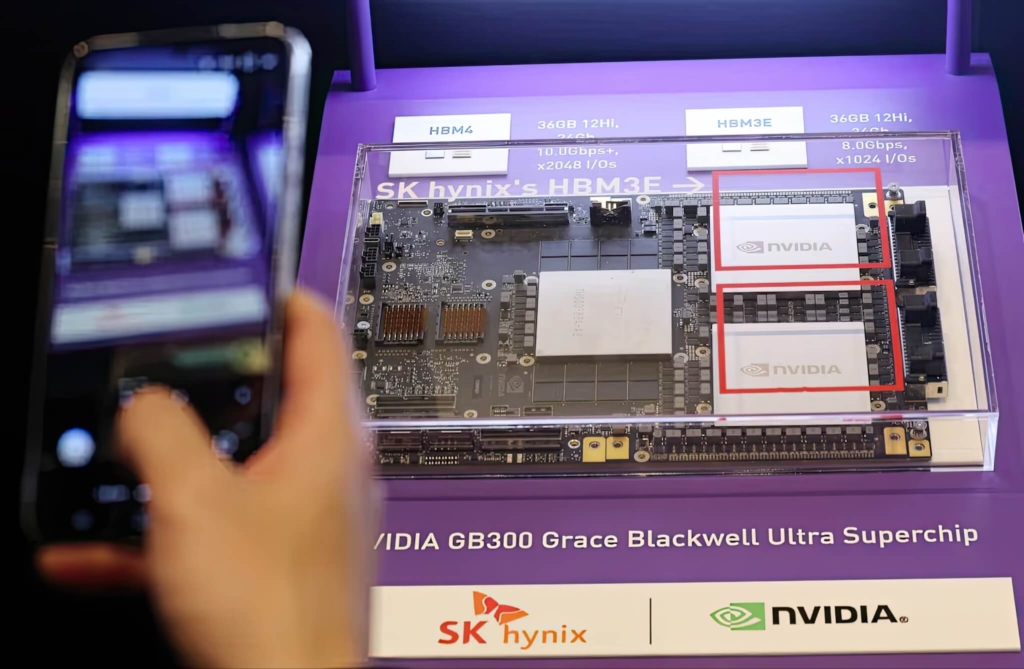

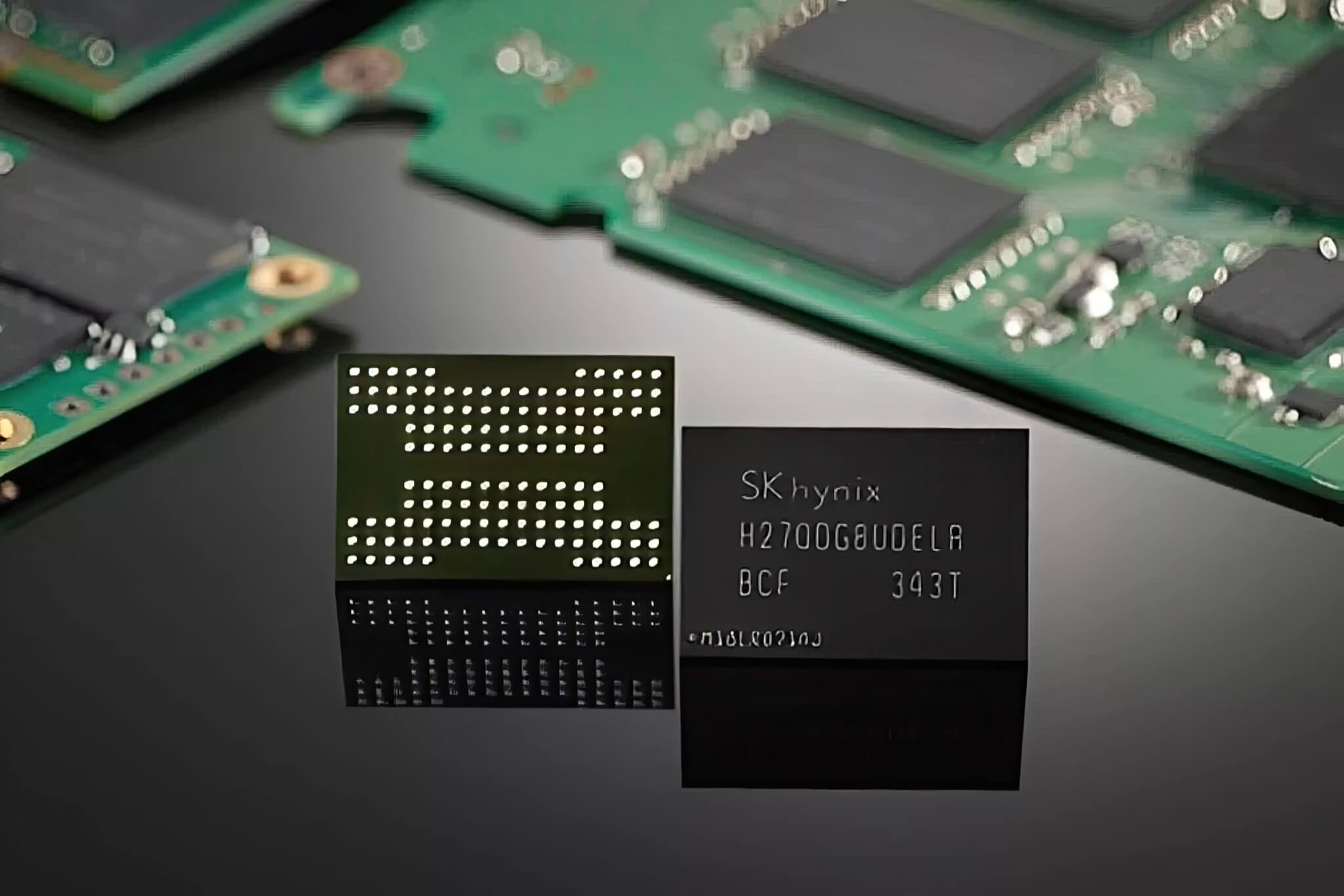

SK Hynix, nhà sản xuất bộ nhớ hàng đầu Hàn Quốc, đang thắt chặt hơn nữa mối quan hệ chiến lược với gã khổng lồ đồ họa Nvidia thông qua việc phát triển một dòng ổ cứng thể rắn (SSD) hiệu năng cao, được tối ưu hóa đặc biệt cho các tác vụ suy luận trí tuệ nhân tạo (AI). Sự hợp tác này đánh dấu một bước mở rộng quan trọng trong quan hệ đối tác giữa hai công ty, vốn trước đây chỉ tập trung vào việc cung cấp bộ nhớ băng thông cao (HBM) cho các GPU AI của Nvidia; lần này, họ đang tấn công mạnh mẽ vào lĩnh vực đổi mới lưu trữ flash NAND với mục tiêu tạo ra chiếc SSD AI có tốc độ nhanh gấp 10 lần hiện nay.

Tham vọng về hiệu suất xử lý SSD AI và cột mốc 100 triệu IOPS

Tại một hội nghị công nghệ diễn ra gần đây, Phó Chủ tịch của SK Hynix, ông Kim Cheon-seong, đã đưa ra một thông báo gây chấn động giới công nghệ. Theo đó, nhà sản xuất bộ nhớ Hàn Quốc đang tích cực làm việc với Nvidia để tạo ra một bước nhảy vọt gấp mười lần về hiệu suất SSD. Dẫn tin từ tờ báo Chosun của Hàn Quốc, ông Kim khẳng định rằng công ty của ông đang phát triển một loại SSD mới với hiệu năng vượt trội gấp 10 lần song hành cùng Nvidia.

Hai công ty đang gọi tên khái niệm mới này dưới hai mật danh nội bộ khác nhau: “Storage Next” tại Nvidia và “AI-NP” – viết tắt của AI NAND Performance (Hiệu suất NAND cho AI) – tại SK Hynix. Hiện tại, quá trình phát triển vẫn đang ở giai đoạn chứng minh ý tưởng (proof-of-concept), với một nguyên mẫu dự kiến sẽ được hoàn thiện trước khi kết thúc năm 2026. Đây là một lộ trình đầy tham vọng nhưng cũng cho thấy sự nghiêm túc của cả hai bên trong việc tái định nghĩa lại khả năng lưu trữ.

Mục tiêu kỹ thuật mà SK Hynix đặt ra cho dòng SSD AI thế hệ tiếp theo này là đạt được con số 100 triệu thao tác nhập/xuất mỗi giây (IOPS). Để độc giả dễ hình dung, con số này cao hơn rất nhiều so với thông lượng của các dòng SSD cấp doanh nghiệp thông thường hiện nay. Việc đạt được quy mô hiệu suất đó sẽ đại diện cho một bước nhảy vọt lớn về mặt kiến trúc phần cứng, giúp thu hẹp khoảng cách một cách hiệu quả giữa bộ nhớ (RAM) và lưu trữ (Storage) trong cơ sở hạ tầng AI.

Giải quyết nút thắt cổ chai và áp lực lên chuỗi cung ứng

Động lực thúc đẩy nỗ lực hợp tác này xuất phát từ những nút thắt cổ chai trong việc truy cập dữ liệu mà các tác vụ AI hiện tại đang gặp phải. Các mô hình suy luận quy mô lớn ngày nay dựa vào việc truy xuất liên tục một lượng khổng lồ các tham số mô hình. Đây là một nhiệm vụ mà các công nghệ bộ nhớ truyền thống như HBM (High Bandwidth Memory) hay DRAM không thể hỗ trợ một cách hiệu quả về mặt quy mô và chi phí. Tầm nhìn cho dự án “Storage Next” là kích hoạt một lớp “giả bộ nhớ” (pseudo-memory layer) sử dụng chip nhớ flash NAND và các công nghệ điều khiển tiên tiến được thiết kế riêng cho tính toán AI thay vì chỉ để lưu trữ dữ liệu thông thường.

Dự án chung này cũng gợi ý về những tác động lan truyền tiềm tàng trên thị trường linh kiện. Chuỗi cung ứng NAND hiện đã và đang chịu áp lực lớn từ nhu cầu ngày càng tăng đối với các dịch vụ đám mây và AI. Sự xuất hiện của một loại SSD AI chuyên dụng có thể làm gia tăng thêm sự căng thẳng đó. Các nhà quan sát trong ngành đã nêu lên khả năng xảy ra một cuộc khủng hoảng nguồn cung tương tự như những gì đã xảy ra với DRAM nếu các giải pháp NAND hiệu suất cao như vậy trở nên phổ biến trong các ứng dụng AI chủ đạo.

Cả SK Hynix và Nvidia dường như đều đang tập trung cao độ vào việc vượt qua các thách thức về thông lượng và hiệu quả năng lượng, những yếu tố đang trở thành giới hạn xác định của cơ sở hạ tầng AI thế hệ hiện tại. Bằng cách tích hợp các kiến trúc bộ điều khiển và NAND tiên tiến hơn, hai công ty đang định vị hiệu quả để lưu trữ flash đóng một vai trò tính toán tích cực hơn trong các khối lượng công việc học máy (machine learning) – một điều mà bộ nhớ truyền thống không thể đạt được về mặt kinh tế.