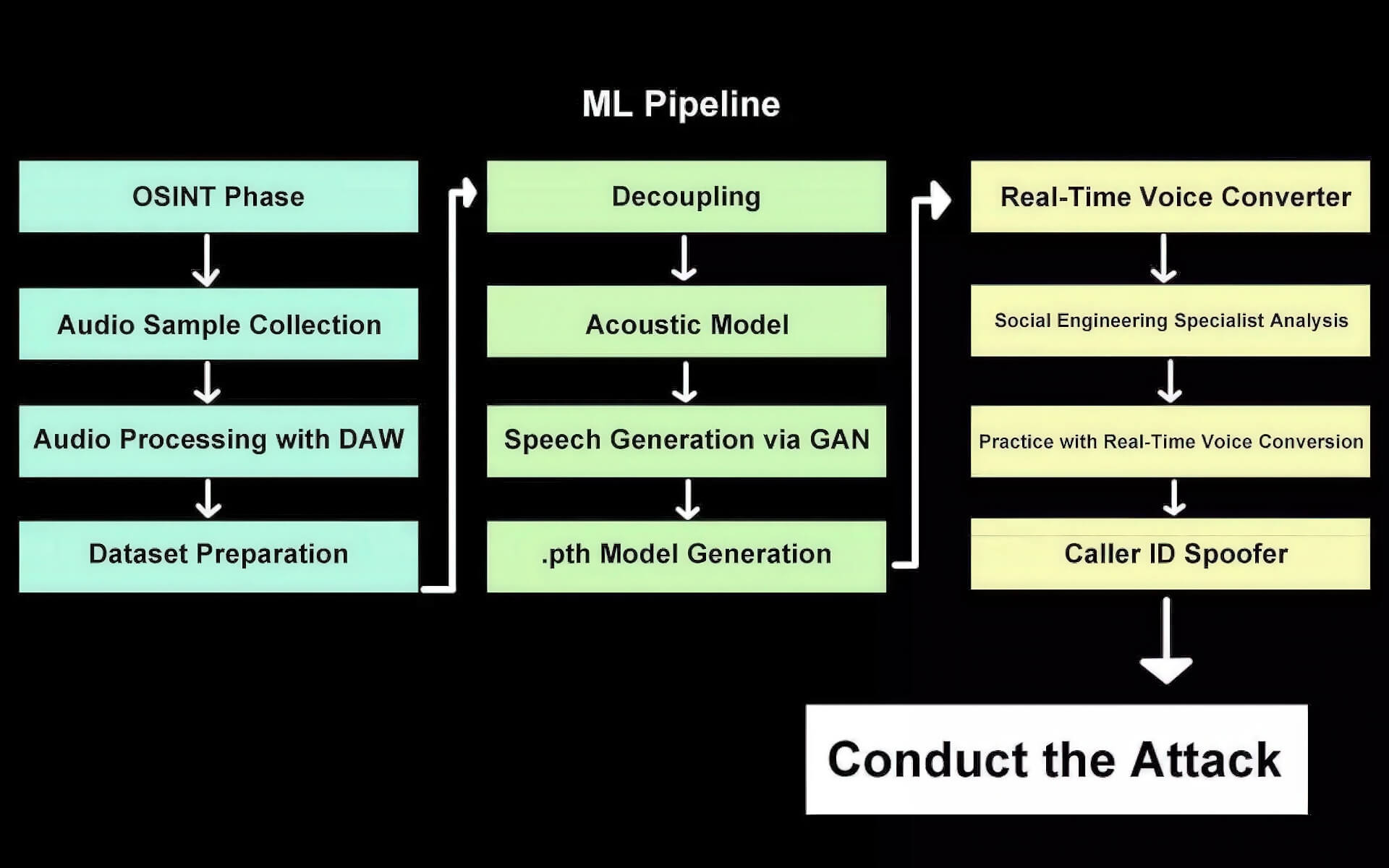

Deepfake giọng nói đã đạt đến một cột mốc đáng báo động: Trí tuệ nhân tạo (AI) giờ đây có thể sao chép giọng nói một cách thuyết phục theo thời gian thực, cho phép kẻ tấn công bắt chước giọng của bất kỳ ai trong một cuộc trò chuyện trực tiếp. Bước đột phá này đã loại bỏ những hạn chế trước đây vốn phụ thuộc vào các đoạn clip ghi âm sẵn hoặc quá trình xử lý chậm chạp, làm dấy lên những lo ngại mới về an ninh mạng và xác minh danh tính. Công ty an ninh mạng NCC Group đã chứng minh rằng việc kết hợp các công cụ AI nguồn mở với phần cứng có sẵn có thể tạo ra deepfake giọng nói theo thời gian thực với độ trễ tối thiểu. Kỹ thuật này, được mệnh danh là “deepfake vishing” (lừa đảo qua điện thoại bằng deepfake), sử dụng các mô hình AI được đào tạo trên các mẫu giọng nói của mục tiêu để tạo ra các màn giả mạo trực tiếp mà người điều hành kích hoạt chỉ bằng một nút bấm trên giao diện web được tùy chỉnh.

“Deepfake Vishing” nguy hiểm: Chỉ cần laptop thông thường để giả mạo giọng nói

Quá trình tạo ra deepfake giọng nói thời gian thực chỉ yêu cầu sức mạnh tính toán khiêm tốn, mặc dù các đơn vị xử lý đồ họa (GPU) cao cấp có thể cải thiện kết quả. Các nhà nghiên cứu đã chạy hệ thống trên một chiếc laptop trang bị GPU Nvidia RTX A1000 – một card đồ họa cấp thấp – và đạt được độ trễ chỉ nửa giây. Các mẫu âm thanh cho thấy hệ thống có thể tạo ra các bản sao giọng nói thuyết phục ngay cả từ các bản ghi âm chất lượng kém. Điều này cho thấy công nghệ có thể hoạt động với micro tích hợp trên các máy tính xách tay và điện thoại thông minh thông thường – làm cho việc sử dụng với mục đích xấu trở nên dễ dàng hơn.

Công nghệ deepfake giọng nói trước đây thường yêu cầu vài phút dữ liệu đào tạo và chỉ tạo ra các đoạn clip được ghi âm sẵn, khiến chúng kém linh hoạt hơn cho các tương tác ngẫu hứng trực tiếp. Khả năng thay đổi giọng nói theo thời gian thực đã loại bỏ những khoảng dừng và sự do dự tự nhiên mà lẽ ra sẽ tiết lộ một nỗ lực giả mạo. Pablo Alobera, Cố vấn An ninh Quản lý tại NCC Group, chia sẻ rằng trong quá trình thử nghiệm có kiểm soát với sự đồng ý của khách hàng, việc kết hợp deepfake giọng nói thời gian thực với giả mạo ID người gọi (caller ID spoofing) đã lừa được mục tiêu trong gần như mọi lần thử. Bước đột phá này cải thiện đáng kể tốc độ và tính chân thực của việc làm giả giọng nói, phơi bày những rủi ro mới ngay cả trong các cuộc gọi điện thoại thông thường.

Deepfake video vẫn còn hạn chế và hệ quả đối với xác thực danh tính

Trong khi deepfake giọng nói đã đạt được những tiến bộ đáng kể, deepfake video thời gian thực vẫn chưa đạt đến mức độ tinh vi tương tự. Các ví dụ lan truyền gần đây sử dụng các mô hình AI tiên tiến như WAN 2.2 Animate của Alibaba và Gemini Flash 2.5 Image của Google (có biệt danh là Nano Banana), những mô hình này có thể cấy ghép kỹ thuật số gần như bất kỳ ai vào các kịch bản video chân thực.

Tuy nhiên, các hệ thống này vẫn gặp khó khăn trong việc tạo ra video chất lượng cao trong các cài đặt trực tiếp và thường thể hiện sự thiếu nhất quán trong biểu cảm khuôn mặt, cảm xúc và đồng bộ hóa lời nói. Trevor Wiseman, người sáng lập công ty an ninh mạng AI the Circuit, nói với IEEE Spectrum rằng sự không khớp giữa giọng điệu và các tín hiệu khuôn mặt vẫn là những điểm yếu dễ nhận thấy ngay cả với những người quan sát không chuyên. Dù vậy, điều này có thể sớm thay đổi khi công nghệ video deepfake tiếp tục được cải thiện.

Sự phổ biến ngày càng tăng của các công nghệ giả mạo này đã dẫn đến những hậu quả hữu hình. Wiseman chỉ ra một trường hợp mà một công ty đã bị lừa trong quá trình tuyển dụng, gửi một chiếc laptop đến một địa chỉ gian lận sau khi bị lừa bởi một deepfake video. Những trường hợp như vậy cho thấy các cuộc gọi thoại và video không thể hoàn toàn đáng tin cậy để xác thực danh tính trong các giao dịch quan trọng.

Giải pháp xác minh danh tính cho kỷ nguyên Deepfake

Khi việc giả mạo bằng AI ngày càng trở nên dễ tiếp cận, các chuyên gia cảnh báo rằng các hình thức xác minh mới sẽ là điều cần thiết. Wiseman ủng hộ việc áp dụng các tín hiệu hoặc mã hóa có cấu trúc, độc đáo – tương tự như các dấu hiệu bí mật được sử dụng trong các trận đấu bóng chày – để xác nhận danh tính một cách rõ ràng trong các tương tác từ xa. Không có các biện pháp như vậy, các cá nhân và tổ chức vẫn gặp rủi ro trước các cuộc tấn công kỹ thuật xã hội (social engineering) ngày càng tinh vi được hỗ trợ bởi deepfake do AI tạo ra. Việc nâng cao nhận thức và triển khai các quy trình xác thực đa yếu tố, đặc biệt là thông qua các kênh không phải giọng nói, sẽ trở nên cực kỳ quan trọng trong thời gian tới.