Trong bối cảnh trí tuệ nhân tạo và điện toán hiệu năng cao ngày càng đòi hỏi bộ nhớ vượt trội về tốc độ, dung lượng và hiệu quả năng lượng, các hãng bán dẫn lớn đang cạnh tranh khốc liệt để phát triển công nghệ bộ nhớ thế hệ mới. Gần đây, SK Hynix đã tạo nên dấu ấn lớn khi trở thành hãng đầu tiên công khai giới thiệu HBM4 – bộ nhớ băng thông cao thế hệ mới, đồng thời cung cấp mẫu thử cho các khách hàng lớn như Nvidia, vượt lên trước Samsung và Micron. Bài viết này sẽ giúp bạn hiểu rõ về đột phá công nghệ HBM4, các đặc điểm kỹ thuật nổi bật cùng ứng dụng thực tiễn trong lĩnh vực AI, GPU và data center.

HBM4 – bước nhảy đột phá về hiệu suất bộ nhớ

HBM4 là thế hệ mới nhất của bộ nhớ băng thông cao High Bandwidth Memory, được SK Hynix phát triển với nhiều nâng cấp mạnh mẽ về dung lượng, tốc độ và công nghệ tích hợp. Điểm nhấn lớn nhất của HBM4 chính là khả năng xếp chồng 16 lớp DRAM (16-Hi stacks), giúp đạt dung lượng tối đa lên tới 48 GB trên một mô-đun – mức cao nhất hiện nay cho dòng HBM. Bên cạnh đó, Băng Thông HBM4 cũng đạt kỷ lục 2.0 TB/s, với tốc độ truy xuất dữ liệu (I/O) lên tới 8.0 Gbps. Đây là con số vượt trội so với các thế hệ trước, mang lại khả năng xử lý lượng dữ liệu khổng lồ trong thời gian cực ngắn.

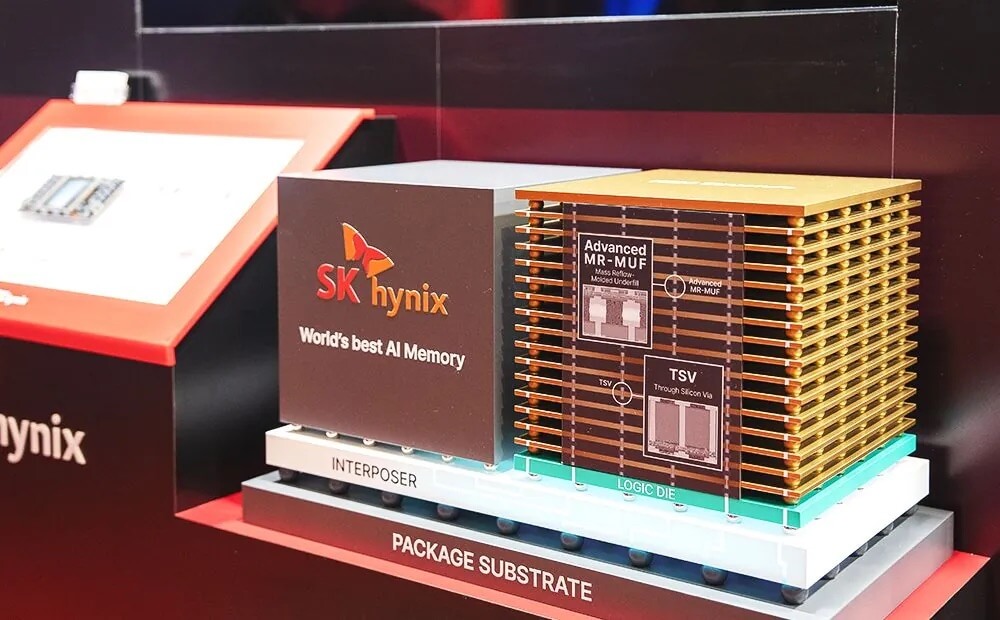

Để đạt được thành tựu này, SK Hynix đã ứng dụng hàng loạt công nghệ tiên tiến như xếp chồng 3D stacking, kết nối TSV (Through-Silicon Via), phương pháp MR-MUF giúp giảm cong vênh chip và nâng cao khả năng tản nhiệt, cũng như tích hợp Logic Die TSMC để tối ưu hiệu năng xử lý. Việc hợp tác chặt chẽ với các đối tác lớn như TSMC không chỉ giúp cải thiện quy trình sản xuất mà còn tăng độ linh hoạt khi tích hợp HBM4 vào các hệ thống AI và GPU thế hệ mới.

Theo lộ trình công bố, SK Hynix sẽ bắt đầu sản xuất hàng loạt HBM4 vào nửa cuối năm 2025, sớm hơn dự kiến nhằm đáp ứng nhu cầu cấp bách từ các ông lớn công nghệ như Nvidia. Điều này củng cố vị thế tiên phong của SK Hynix, khi các đối thủ như Samsung và Micron vẫn đang trong giai đoạn thử nghiệm mẫu HBM4 và chưa thể thương mại hóa rộng rãi.

Ứng dụng thực tiễn và lợi thế cạnh tranh của HBM4

Không chỉ là bước tiến về mặt công nghệ, HBM4 còn mở ra nhiều ứng dụng thực tiễn trong các lĩnh vực đòi hỏi xử lý dữ liệu tốc độ cao và dung lượng lớn. Đầu tiên, HBM4 là lựa chọn lý tưởng cho các GPU cao cấp phục vụ AI, deep learning, render đồ họa chuyên nghiệp, trung tâm dữ liệu và siêu máy tính. Nhờ khả năng truyền tải dữ liệu với băng thông cực lớn, HBM4 giúp giảm độ trễ nghẽn dữ liệu, tăng tốc độ huấn luyện và suy luận cho các mô hình AI, cũng như nâng cao hiệu suất xử lý hình ảnh, video, gaming 8K hoặc render 3D.

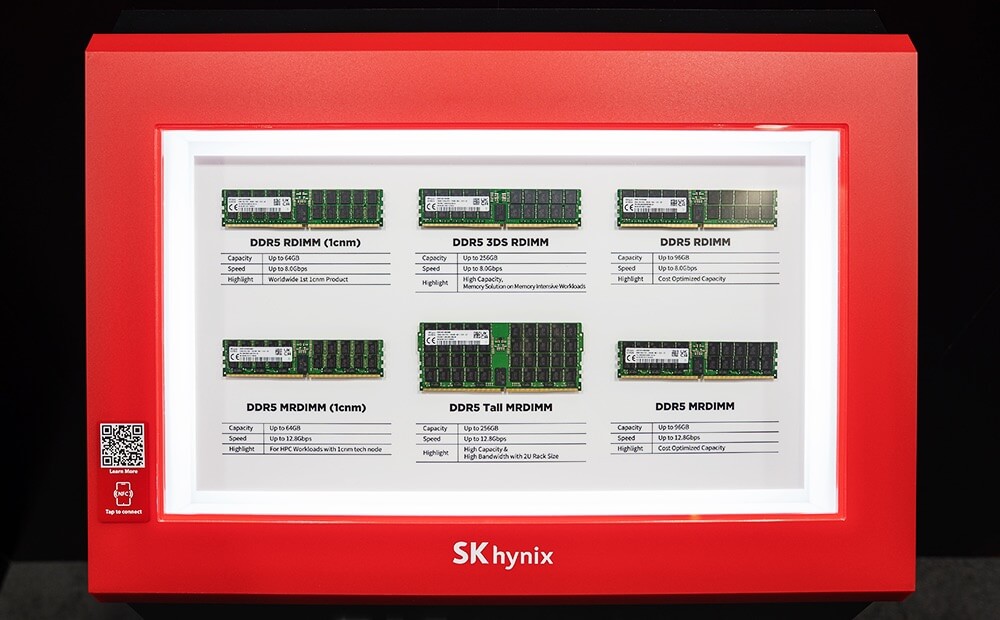

Ngoài HBM4, SK Hynix còn ra mắt Hbm3E 16 lớp (1.2 TB/s), các module RDIMM, MRDIMM tốc độ tối đa 12.8 Gbps, dung lượng lên tới 256 GB – đáp ứng nhu cầu đa dạng từ server truyền thống đến AI và data center hiện đại. Những sản phẩm này đều được tối ưu hóa cho môi trường xử lý dữ liệu hỗn hợp, giúp giảm tiêu thụ năng lượng và nâng cao độ ổn định của hệ thống.

Sự kiện ra mắt HBM4 tại TSMC 2025 North America Technology Symposium không chỉ khẳng định vai trò dẫn đầu của SK Hynix trong lĩnh vực AI memory, mà còn tạo lợi thế cạnh tranh rõ rệt trước Samsung và Micron. Khi các đối thủ vẫn đang hoàn thiện công nghệ, SK Hynix đã nhanh chóng đưa HBM4 ra thị trường, sẵn sàng đáp ứng nhu cầu bùng nổ từ các hãng công nghệ lớn, đặc biệt là Nvidia – đơn vị đang cần bộ nhớ tốc độ cao cho các dòng GPU AI thế hệ mới.

Tuy nhiên, SK Hynix cũng phải đối mặt với không ít thách thức. Việc đẩy nhanh lịch trình sản xuất hàng loạt HBM4 tạo áp lực lớn lên chuỗi cung ứng, sản xuất và kiểm soát chất lượng sản phẩm. Đồng thời, cuộc đua với những ông lớn như Samsung và Micron dự báo sẽ còn gay gắt hơn khi nhu cầu thị trường bộ nhớ AI tiếp tục tăng mạnh trong thời gian tới.

Tóm lại: HBM4 của SK Hynix không chỉ là bước tiến lớn về mặt công nghệ bộ nhớ, mà còn góp phần thay đổi cuộc chơi trong lĩnh vực AI, deep learning, đồ họa và data center. Với dung lượng 48 GB, 16 lớp xếp chồng, băng thông 2.0 TB/s và tích hợp công nghệ Logic Die TSMC, HBM4 mang lại hiệu suất vượt trội, giúp các hệ thống GPU cao cấp xử lý dữ liệu khổng lồ một cách nhanh chóng, tiết kiệm năng lượng. Việc SK Hynix tiên phong thương mại hóa HBM4 tạo lợi thế cạnh tranh lớn, đáp ứng kịp thời nhu cầu từ các hãng công nghệ dẫn đầu như Nvidia, đồng thời khẳng định vị thế số một trong cuộc đua bộ nhớ AI thế hệ mới.