Trong khi nhiều mô hình ngôn ngữ lớn (LLM) yêu cầu phần cứng mạnh và tiêu tốn nhiều tài nguyên, Microsoft’s Bitnet xuất hiện như một làn gió mới, mang đến giải pháp AI siêu nhẹ, dễ tiếp cận và tiết kiệm năng lượng vượt trội. Được phát triển bởi Microsoft, Bitnet không chỉ gây chú ý nhờ khả năng chạy mượt mà trên CPU phổ thông mà còn mở ra cơ hội phổ cập AI tới hàng triệu thiết bị cá nhân, edge device mà trước đây vốn phụ thuộc vào cloud hoặc GPU chuyên dụng.

Bitnet là gì? Đột phá công nghệ lượng tử hóa 3 mức

Bitnet b1.58 2B4T, sản phẩm mới nhất từ Microsoft, là mô hình ngôn ngữ lớn (LLM) với 2 tỷ tham số nhưng chỉ cần 400MB bộ nhớ – nhỏ gọn hơn rất nhiều so với các đối thủ như Gemma 3 1B (1.4GB). Đặc biệt, Bitnet có thể vận hành hoàn toàn trên CPU phổ thông, kể cả các chip tiết kiệm điện như Apple M2 mà không cần GPU đắt đỏ. Điều này giúp AI trở nên gần gũi, dễ tiếp cận hơn với cá nhân, doanh nghiệp nhỏ, hoặc các thiết bị IoT, laptop siêu mỏng.

Điểm sáng tạo nổi bật của Bitnet là sử dụng công nghệ lượng tử hóa 3 mức (ternary quantization), khi mỗi trọng số chỉ nhận giá trị -1, 0 hoặc +1 thay vì 16/32-bit float truyền thống. Nhờ đó, mỗi tham số chỉ chiếm 1.58 bit, giúp giảm mạnh dung lượng lưu trữ và tăng hiệu quả tính toán. Khác với các phương pháp nén model sau huấn luyện, Bitnet được huấn luyện trực tiếp với trọng số 3 mức ngay từ đầu, đảm bảo hiệu năng không bị suy giảm trong quá trình chuyển đổi.

Framework bitnet.cpp được tối ưu riêng cho mô hình này, cho phép vận hành nhanh, nhẹ trên CPU, và hiện đã hỗ trợ các dòng chip ARM, x86. Microsoft cũng phát hành Bitnet dưới giấy phép mã nguồn mở MIT, giúp cộng đồng dễ dàng tiếp cận, thử nghiệm và phát triển ứng dụng AI trên nhiều nền tảng khác nhau.

So sánh Bitnet với các mô hình AI truyền thống và ứng dụng thực tiễn

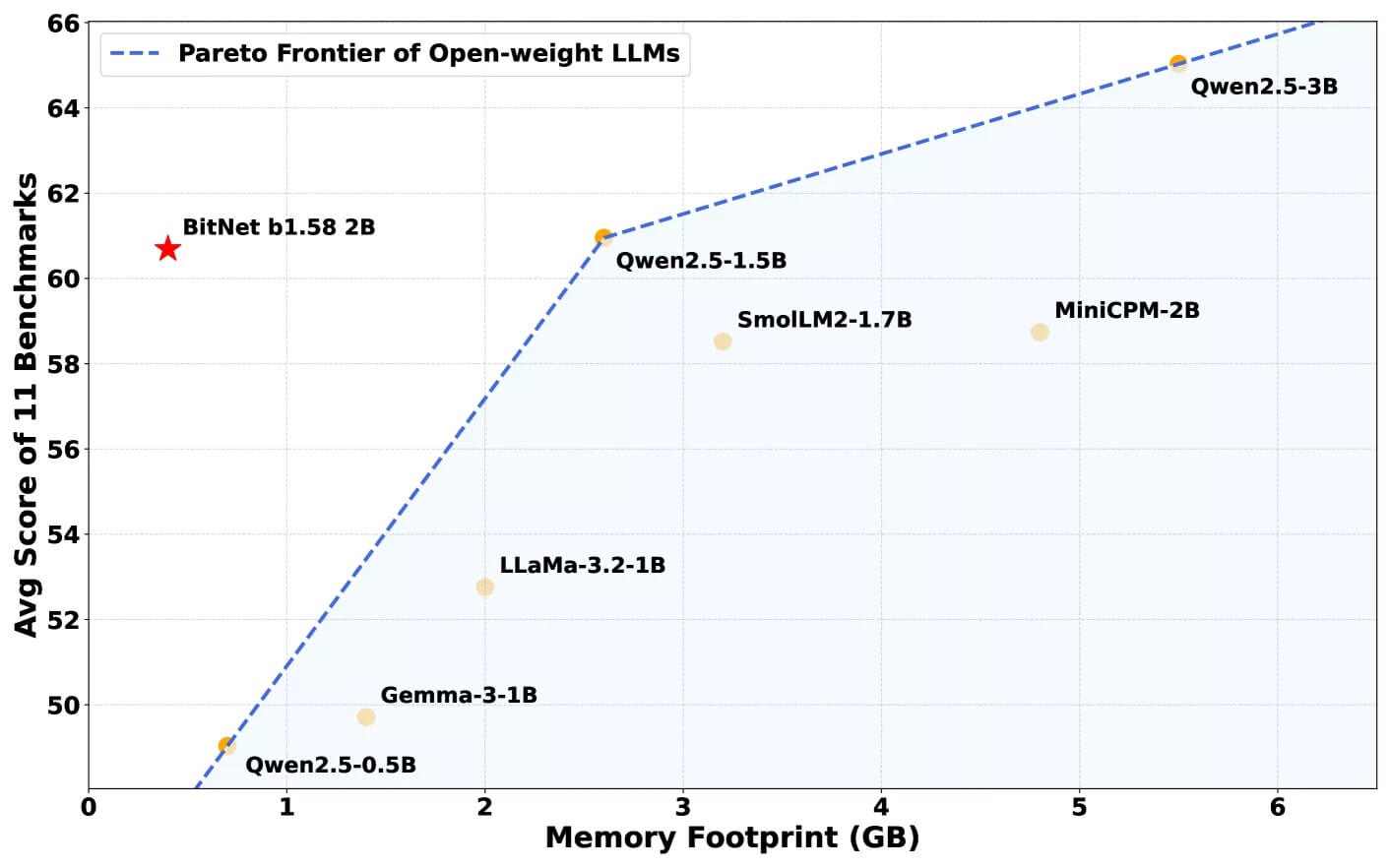

So với các mô hình như Llama 3.2 1B, Gemma 3 1B, Qwen 2.5 1.5B, Bitnet có nhiều lợi thế vượt trội:

- Kích thước chỉ 400MB, nhỏ hơn nhiều lần so với các mô hình cùng phân khúc, giúp tiết kiệm bộ nhớ và giảm chi phí phần cứng.

- Hiệu năng thực tế trên các bài kiểm tra toán học, suy luận thông thường ngang ngửa hoặc thậm chí vượt trội các đối thủ, dù chỉ chạy trên CPU phổ thông.

- Không cần GPU, giảm đáng kể chi phí vận hành và tiêu thụ năng lượng, phù hợp cho các thiết bị cá nhân, edge device, laptop siêu mỏng hoặc hệ thống IoT.

- Tiêu thụ năng lượng thấp hơn 85–96% so với các mô hình full-precision cùng quy mô, góp phần giảm tác động môi trường.

- Mã nguồn mở, dễ tiếp cận và thuận tiện cho cộng đồng phát triển, tích hợp AI vào các sản phẩm, dịch vụ mới.

Bitnet cũng đánh dấu sự khác biệt lớn so với các phương pháp nén model truyền thống: mô hình này được huấn luyện trực tiếp với trọng số 3 mức, tránh mất mát hiệu năng do chuyển đổi sau huấn luyện.

Tuy nhiên, Bitnet vẫn còn một số hạn chế nhất định. Hiện tại, mô hình chỉ hỗ trợ chạy trên CPU và cần framework bitnet.cpp tùy chỉnh. Ngoài ra, cửa sổ ngữ cảnh (context window) nhỏ hơn so với các mô hình tiên tiến nhất, hạn chế khả năng xử lý văn bản dài. Microsoft cho biết sẽ tiếp tục phát triển để mở rộng hỗ trợ phần cứng, tăng kích thước context window và bổ sung nhiều ngôn ngữ hơn trong tương lai.

Tóm lại: Bitnet đang mở ra kỷ nguyên mới cho AI tiết kiệm tài nguyên, giúp phổ cập sức mạnh của trí tuệ nhân tạo đến mọi thiết bị, từ điện thoại, laptop đến edge device, mà không cần đến hạ tầng phần cứng đắt đỏ. Với công nghệ lượng tử hóa 3 mức độc đáo, hiệu năng cạnh tranh, khả năng tiết kiệm năng lượng và mã nguồn mở, Bitnet là lựa chọn lý tưởng cho cá nhân, doanh nghiệp nhỏ và cộng đồng phát triển AI hiện đại. Dù còn một số giới hạn, nhưng tiềm năng phát triển và ứng dụng thực tiễn của Bitnet là rất lớn, hứa hẹn thúc đẩy xu hướng AI xanh, phổ cập AI mạnh mẽ trên toàn cầu.